|

|

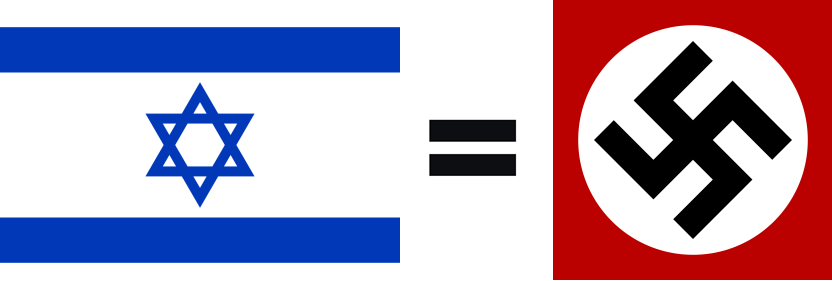

Zionismens folkemord i Palæstina er i dag et barbari, der overgår nazismens terror i Europa under 2. Verdenskrig. Palæstinenserne er i dag verdens jøder, og zionisterne deres bødler |

Computer

En computer (dansk: datamaskine, elektronisk databehandling (EDB)) er en enhed der anvendes til behandling af informationer ud fra veldefinerede procedurer. Begrebet blev på engelsk oprindelig anvendt om mennesker, der var ansat til at udføre aritmetiske beregninger - med eller uden mekaniske hjælpemidler - men det udvikledes siden til at beskrive hjælpemidlerne selv. Oprindelig var informationsbehandlingen helt koncentreret omkring aritmetiske problemer, men moderne computere anvendes til mange formål, der ikke er matematiske. Vi arbejder her med et computerbegreb der strækker sig fra de første mekaniske enheder til moderne elektroniske computere.

De tidligste enheder

Menneskeheden har kendt til hjælpemidler ifbm. beregninger i flere tusinde år. Et eksempel er den østasiatiske abacus. De første maskiner der mere eller mindre automatisk kunne nå frem til løsningen på en aritmetisk opgave blev bygget i det 17. århundrede. De var i første omgang begrænset til at kunne udføre addition og subtraktion, men blev senere videreudviklet til at kunne klare multiplikation. Disse maskiner var baseret på anvendelsen af tandhjul, der oprindelig var udviklet til ure. Differens-motoren fra det 19. århundrede kunne udføre lange serier af sådanne udregninger med det formål at opbygge matematiske tabeller, men den var ikke særlig udbredt.

Et kendetegn ved den universelle computer er, at den kan programmeres. Dvs. at den kan bringes til at kopiere enhver anden regnemaskine ved at tilpasse dens sæt af instruktioner. I 1801 byggede Joseph-Marie Jacquard en væv, i hvilken det vævede mønster blev styret af hulkort. Serien af kort og dermed det vævede mønster kunne udskiftes uden at ændre vævens mekaniske design. Dette var en milepæl i programmeringen af maskiner.

I 1833 beskrev Babbage sin analytiske motor. Det var en plan for en generelt anvendelig programmerbar mekanisk computer, baseret på anvendelsen af hulkort som input og dampkraft som energi. Planerne var korrekte, men den manglende præcision i datidens mekaniske teknologi gjorde maskinen umulig at bygge.

I 1890 anvendte USA's Folketællingskontor en maskine baseret på hulkort, designet af Herman Hollerith, der senere grundlagde IBM.

Elektriciteten som energikilde

I det 20. århundrede begyndte man at anvende elektricitet som energikilde for regnemaskiner. Helt frem til 1970'erne og 80'erne blev regnemaskiner anvendt på almindelige kontorer og i hjemmet drevet af en elektromotor. Før 2. verdenskrig var både mekaniske og analoge computere relativt udbredte. I den analoge computer bestemte størrelsen af en spænding, en strøm eller hastigheden hvormed aksler roterede, hvad der blev regnet på. I modsætning til digitale computere var de ikke særlig fleksible og måtte omprogrammeres eller ombygges for at skifte fra en beregning til en anden. Til gengæld havde de den fordel over tidlige digitale computere, at de kunne anvendes til langt mere komplicerede beregninger. Men efterhånden som de digitale computere er blevedt hurtigere, har de næsten fuldstændig fortrængt de analoge computere.

I årene frem til 2. verdenskrig og under krigen skete der en hastig teknologisk udvikling, der også medførte et spring fremad for regnemaskine teknologien. Enhederne var først og fremmest elektromekaniske - elektriciteten var drivkraften, men regnemaskinerne var fortsat afhængige af bevægelige mekaniske dele. Især relæer. I 1938 indledte tyskeren Konrad Zuse udviklingen af sin Z-serie af maskiner, der var elektromekaniske regnemaskiner med hukommelse og begrænset programmerbarhed. Han arbejdede for det tyske militær, der bl.a. anvendte hans maskiner i produktionen af styrede missiler. Z-serien var banebrydende på flere områder. Den anvendte binær aritmetik og kunne regne med «flydende tal». I 1940 blev der bygget en regnemaskine der kunne regne med komplekse tal. Også den var baseret på relæer, men den var den første maskine, der kunne betjenes over en telefonforbindelse.

I krigsårene spillede den britiske matematiker Alan Turing en vigtig rolle for udviklingen af den moderne computer. Han arbejdede sammen med andre om at bryde de tyske kodede meddelelser, og dette arbejde ledte i 1943 til udviklingen af Colossus maskinen. Den var bestykket med radiorør, og havde altså brudt den mekaniske begrænsning i de elektromekaniske maskiner. Den var bygget specielt til at knække de tyske koder, fik sit input fra en papirstrimmellæser og var i begrænset omfang programmerbar. Englænderne byggede ialt 10 af disse kode-knækkere, men både deres eksistens og design var en britisk statshemmelighed frem til 1970'erne.

Turings matematiske teoretiske arbejde fik ligeledes betydning for udviklingen af den moderne computer. Allerede i 1936 havde han skitseret en «Turing maskine» - en rent teoretisk enhed, der formaliserede betydningen af begrebet algoritme. Turings arbejde blev brugt til at skelne mellem tidligere tiders specialiserede regnemaskiner og generelt anvendelige - programmerbare - regnemaskiner (computere). Udfra denne kategorisering var Babbages analytiske motor fra 1836 den første computer, men den var en rent teoretisk konstruktion. Zuzes Z3 maskine var i realiteten den første computer, men uden at Zuze dog vidste dette. Den nordamerikanske ENIAC maskine var den første maskine der blev designet udfra Turings retningsliner.

Den første generation

Omkring verdenskrigen tog computeren form. De krigsførende magter erkendte behovet for omfattende beregninger ifbm. udviklingen af nye våben som missiler og atombomben. Udviklingen blev derfor langt overvejende gennemført med statslig finansiering. Teknisk skete der et skift fra analoge til digitale maskiner. Relæer blev erstattet af de langt hurtigere radiorør. Hulkort og papirstrimmel blev anvendt som input-medium og varigt lagringsmedium, mens akustiske forsinkelseskredsløb og senere Williams rør blev anvendt til at gemme arbejdsdata. Fra 1954 begyndte lagre baseret på magnetkerner at fortrænge andre lagringsmedier, og magnetlagrene fik en dominerende stilling helt frem til slutningen af 1970'erne.

Harvard Mark I var en generel elektromekanisk maskine, der blev bygget af IBM ingeniører i samarbejde med Harvard matematikeren Howard Aiken. Udviklingen indledtes i 1939 i IBM's Endicott laboratorier og blev flyttet til Harvard Universitetet som færdig og funktionsdygtig maskine i 1944.

I 1941 indledte USA udviklingen af ENIAC (Electronic Numerical Integrator and Computer) maskinen. Det var den første rent elektroniske maskine, hvilket gav den en enorm hastighedsfordel over sine forgængere. Den var 1000 gange hurtigere, fordi relæerne var erstattet af radiorør. Den bestod af 18.000 af slagsen, vejede 30 tons og forbrugte 25kW, da den endelig stod færdig i 1945. Da designet blev forslået, mente mange forskere, at radiorørene ville brænde ud så hurtigt, at maskinen ville være ubrugelig, men i praksis viste maskinen sig i stand til at udføre 100.000 operationer pr. sekund i timevis, mellem at rør udbrændte.

Den ungarske matematiker Johannes von Neumann havde deltaget i udviklingen af ENIAC, og allerede da den stod funktionsklar var han i gang med planerne for dens efterfølger, EDVAC. Hans vigtigste bidrag var ideen om, at både program og data skulle lagres i computerens hukommelse, hvor de blev tilgået af en enkelt regneenhed - i modsætning til ENIAC der havde flere parallelle regneenheder. EDVAC nåede aldrig at blive bygget, men «von Neumann» arkitekturen blev det grundlag de efterfølgende computere blev udviklet udfra over hele verden, og vore dages computere har fortsat grundlæggende en von Neumann arkitektur. Den første fungerende von Neumann maskine var den såkaldte Manchester «Baby», der blev bygget på Manchester University i 1948. Den blev prototypen for Ferranti Mark I. Verdens første kommercielt producerede computer, der blev produceret i 1951-57.

I USA blev den første kommercielle computer (UNIVAC I - Universal Automatic Computer) leveret til USA's Statistiske kontor i 1951. Den blev bygget af Remington Rand, bestod af 5.200 radiorør og forbrugte 125kW. Remington Rand endte med at producere ialt 46 af slagsen til en pris af 1 mio. US$ stykket.

Udviklingen blev i efterkrigsårene fortsat drevet af militæret og sekundært af de meget store offentlige kunder. Den kolde krig rasede og USA brugte fortsat store summer på militær udvikling, hvor computeren spillede en vigtig rolle ifbm. beregninger og simulationer. ENIAC blev f.eks. anvendt til at gennemføre beregninger der skulle vise, om brintbomben overhovedet ville virke, og til at lave ballistiske beregninger der skulle muliggøre udviklingen af langtrækkende atomvåbenbærende raketter.

2. generation - den kommercielle mainframe

Relæerne var i 1940'erne blevet erstattet af radiorør, der dramatisk havde øget regnehastigheden. Bagdelen var, at maskinerne i bedste fald kun kunne køre nogle timer inden de skulle repareres. Rørene brændte hurtigt ud. Løsningen på dette problem blev transistoren. Den blev opfundet i 1947, var langt mindre, brugte mindre energi og havde en meget længere levetid. Fra slutningen af 1950'erne til slutningen af 1960'erne blev den den centrale komponent i den 2. generation af computere.

I 1960 producerede IBM sin første 1401 model, der var transistor baseret og med et magnetkernelager på 4000 karakterer. Det blev en meget populær maskine, der endte med at blive produceret i 12.000 eksemplarer. Virksomhedens førende stilling indenfor computerproduktion blev dermed slået fast. Siden starten af århundredet havde den produceret bl.a. hulkortmaskiner til de store offentlige myndigheder og de største koncerner. Virksomheden satsede på at bevare denne position som vigtig leverandør til især det offentlige og de store koncerner, og det lykkedes.

I 1964 begyndte IBM at producere S/360 serien. Med den slog koncernen sit ry fast som dominerende aktør i den voksende computer branche. Serien var på flere måder banebrydende: den gjorde det muligt at køre de samme programmer på maskiner, der varierede bredt i hastighed, kapacitet og pris; dens operativsystem var det første kommercielt tilgængelige multi-programmerings system, der gjorde det muligt for mange brugere samtidigt at udnytte maskinens kapacitet; den forenede flere tidligere tidligere produktlinier af kommercielle og videnskabelige maskiner til en platform og havde et mikroprogrammeret instruktionssæt, der var designet til at håndtere mange forskellige typer af informationer - ikke blot aritmetiske. Serien blev en stor kommerciel succes og arkitekturen kom grundlæggende til at holde i 20 år. Alene de første 4 år producerede IBM 14.000 maskiner i serien. Datakraften blev stadig billigere og maskinerne blev anvendt i stadig mindre offentlige og private organisationer. Samtidig forsøgte IBM at forstærke sin markedsmæssige dominans ved at forære maskinerne til universiteterne og de højere læreanstalter, så nyuddannede ingeniører og videnskabsmænd var vandt til at bruge IBM.

Mens europæerne havde været videnskabeligt og teknologisk førende på computer området op til og i årene umiddelbart efter 2. verdenskrig, slog udviklingen af 2. generationsmaskinerne USA's førerstilling fast. De fleste store industrilande satte godt nok udviklingsprojekter i gang og producerede computere, mens dels var markedet i USA langt større, militæret betalte for betydelige dele af udviklingen, og de nordamerikanske producenter havde bedre adgang til de komponenter der skulle anvendes - først og fremmest transistorer. Endelig var Europa mærket af 2. verdenskrigs ødelæggelser frem til starten af 60'erne.

3. generation - mini computeren

En væsentlig skranke for spredningen af de store mainframe computere som IBM's S/360 var imidlertid deres størrelse, pris og den organisation der skulle lægges i at få dem til at fungere. Det krævede specielt airconditionerede rum for at holde temperaturen nede og et hold af eksperter til at holde computerne kørende. I 1958 blev det første integrerede kredsløb (eng. Integrated Circuit, IC) produceret af Texas Instruments, og fra midten af 1960'erne blev de anvendt i de fleste computere. IC teknologien gjorde det muligt at kombinere mange transistorer i en enkelt komponent. Det øgede hastigheden, mindskede energiforbruget og gjorde først og fremmest maskinerne billigere. IBM brugte denne udvikling til at udvikle stærkere og større maskiner i S/360 serien. Det lille firma Digital Equipment Corporation (DEC) brugte i stedet teknologien til at producere «små» maskiner på størrelse med et stort køle-fryseskab. I 1964 sendte firmaet sin PDP-8 på markedet. Minicomputeren var født. Den var langt mindre og langt billigere end mainframemaskinerne og krævede mindre organisation omkring sig. Den kunne derfor anvendes i mindre virksomheder, for hvem mainframes var for store, dyre og klodsede. PDP-8 blev fulgt af PDP-11 og senere VAX serierne, så fra starten af 1970'erne var DEC den næststørste computerproducent - efter IBM.

4. generation - mikro computeren

I 1971 producerede IC virksomheden Intel den første mikroprocessor - ved et tilfælde. Den var egentlig specialudviklet til en japansk lommeregner, men japanerne kunne alligevel ikke bruge den, og Intel gjorde i stedet sin 4 bit 4004 kommercielt tilgængelig. Hele computerens centralenhed (CPU) var dermed samlet på en enkelt chip. Det var kun 13 år siden de første IC'er var udviklet. 4004 rummede 2.300 transistorer. En af Intels grundlæggere - Gordon Moore - formulerede Moores lov: at antallet af transistorer i chips fordobles for hver 18 måneder. Intels 4004 blev fulgt af 8008, 8080 og i 1978 af 8086, hvis instruktionssæt og arkitektur fortsat er bærende i PC'er.

Udviklingen indenfor halvlederteknologien revolutionerede computer branchen langt mere end introduktionen af transistorer havde gjort. Endnu vigtigere end enkelt chips CPU'en var udviklingen af hukommelseschips. Helt frem til slutningen af 60'erne var lagermediet i computerne næsten udelukkende ferritkerne lagre, men i IBM's laboratorier udvikledes hukommelses IC'er - RAM (Random Access Memory) og ROM (Read Only Memory). Der blev udviklet dynamiske RAM'er, hvor hver bit blot krævede en enkelt transistor og en kondensator på chippen. Stadig større RAM chips blev målestokken for den halvlederteknologiske udvikling, og i løbet af 1970'erne skete der et lavineagtigt skred i lagringsmedierne fra ferritkerne lagre til RAM. RAM produktionen var samtidig lukrativ, for mens der kun skulle bruges 1 CPU i en computer, skulle der bruges 16, 64 eller i hundredvis af RAM kredse.

Mens USA siden 50'erne havde cementeret sin dominans over computer industrien, blev denne dominans fra midten af 70'erne truet. Masseproduktionen af IC'er - specielt RAM og ROM kredsløb - blev i stigende grad domineret af Japan og senere hen Sydkorea og Taiwan. I USA blev der i regeringskredse formuleret en frygt for, at strategisk kerneteknologi var på vej til at glide USA af hænde. Strategisk - ikke blot økonomisk, men også militært - fordi USA i stigende grad blev afhængig af hukommelseskredse produceret i Asien. Men selvom USA mistede kontrollen over hukommelsesproduktionen, var supermagten foreløbigt i stand til at bevare kontrollen på 2 andre strategiske områder: produktionen af mikroprocessorer og af programmer. Ifht. mikroprocessor udviklingen blev konkurrenter hindret i at trænge ind ved at udviklingsomkostningerne var langt højere end for RAM kredse, kvanta var mindre, Intel havde mere eller mindre monopol på instruktionssættet der blev anvendt i en stadig større del af verdens computere, og USA var i stand til at bevare den videnskabelige førerstilling i udviklingen af ny processor arkitektur. Ifht. programmer udgjorde USA det største marked, og det var engelsksproget, hvilket var en barriere for konkurrence fra bl.a. Japan.

CPU IC'er og RAM'er var rygradden i den 4. generation af computere: mikro computerne. De var endnu mindre og billigere end deres forgængere. Det medførte, at markedet fortsatte med at vokse. Selv små virksomheder og institutioner havde råd til at anskaffe sig en computer. Og computeren begyndte fra midten af 70'erne at blive en konsum vare. I 1975 blev det første personlige computer byggesæt, Altair, produceret. Det blev en stor succes. Over 10.000 maskiner blev produceret. To unge nørder, Bill Gates og Paul Allen udviklede en Basic oversætter til denne maskine. Senere i 1975 grundlagde de Microsoft. I disse år anvendte de fleste af disse små maskiner operativsystemet CP/M. Det var dette system Gates og Allen nogle år senere huggede, skrev om og solgte som DOS (Disk Operating System) til IBM.

To andre aktører i mikro computer branchen var Steve Wozniak og Steve Jobs, der i 1977 producerede deres første Apple II. Denne lille mikro computer var noget dyrere end konkurrenterne, men havde til gengæld farvegrafik og nogle bedre tekniske egenskaber. Den blev derfor valgt som platform for et nyt program, ingen tidligere havde udviklet. Daniel Bricklin og Bob Frankston udviklede regnearks programmet, VisiCalc, der gjorde det muligt for mindre virksomheder at opstille regnskaber og lave beregninger, visuelt opstillet. Programmet var det første af sin art og blev en enorm succes, hvilket trak endnu flere software udviklere til Apples platform. Maskinen blev utroligt populær i mindre virksomheder og blev også købt af mange private. Apple producerede 2 millioner af slagsen i 1977-83.

Apples maskine blev fulgt af mange andre som Commodores VIC-20, Commodore 64 og Amiga, Atari, Amstrad og Sinclair. IBM erkendte, at virksomheden var ved at miste grebet om markedet. Mini computer vognen var for længst kørt, og nu var IBM også ved at miste taget om det hastigt voksende marked for micro computere. I 1981 dannede koncernen derfor en ny og adskilt enhed, der skulle tage kampen op mod Apple og de andre nytilkomne i branchen. Den udviklede en personlig computer (PC) og selv om konkurrenterne også producerede personlig computere, fik IBM fra midten af 80'erne monopol på PC betegnelsen. IBM havde ikke selv tid til at udvikle et operativsystem til sin nye maskine, og besluttede i stedet at købe et sådan ude i byen. CP/M var på den tid det mest avancerede system til de små maskiner, men IBM valgte i stedet DOS (Disk Operating System), der var en billig CP/M klon fra den lille virksomhed Microsoft.

PC'en erobrer verden

I 1983 tog Apple kampen op med sin grafisk og muse-baserede Lisa maskine, og den blev året efter fulgt af Macintosh, der blev en stor succes. Lige siden da har Apples maskiner udmærket sig ved at være grafisk mere avancerede og mere brugervenlige end IBM's maskiner. Men IBM havde et navn og en aggressiv markedsføringsorganisation. Samtidig var IBM's arkitektur åben, mens Apples var lukket. IBM havde ikke noget imod, at konkurrenter kopierede arkitekturen og producerede «IBM kompatible PC'er». IBM's åbne PC arkitektur endte med at vinde slaget. De første PC kloner blev produceret af det nystartede firma Compaq. De blev hurtigt fulgt af andre, endnu flere lavede printere, grafikkort, harddiske osv. til de nye maskiner. Og programproducenterne flokkedes omkring PC arkitekturen, der gav adgang til et hastigt voksende marked.

Arkitekturen var ikke den mest geniale - et problem også nutidens PC'er slæber rundt på - og operativsystemerne fra Microsoft - DOS og senere Windows - var heller ikke de mest geniale, men PC markedet var ubestridt det største, og sugede derfor udviklings- markedsføringsressourcer til sig. Disse masseproducerede maskiner var billige. Konkurrencen var benhård. Og samtidig muliggjorde massemarkedet markedsføringen af avancerede billige programmer. De PC baserede maskiner væltede derfor ud. Ikke blot ind i folks private hjem, men også ind i virksomhederne, på kontorene og i maskinerne på arbejdspladsen. På de store arbejdspladser blev computer strukturen revolutioneret. Tidligere havde man haft centrale servere - ofte produceret af IBM - som folk benyttede via «dumme» skærmterminaler. PC'erne flyttede computerkraften fra de airconditionerede rum ud på medarbejdernes skriveborde. IBM havde startet en revolution - eller var i hvert fald hoppet med på vognen - men havde samtidig trukket tæppet væk under sig selv. Der produceres fortsat mainframes, men det er blot et lille specialiseret hjørne af den samlede produktion. Næsten alle producenterne af mini computere er gået konkurs eller blevet opkøbt. PC klon producenten Compaq købte DEC, der tidligere var verdens næststørste computer producent. Nu er Compaq selv opkøbt af Hewlett Packard.

Mikro computerne har fuldstændig udkonkurreret mini computerne, i takt med at de selv er blevet kraftige nok til at fungere som database- og filservere. Læren er, at branchen siden 1960'erne har gennemgået så voldsomme teknologiske og økonomiske omvæltninger, at kun enkelte virksomheder har været i stand til at tilpasse sig og overleve. Det gælder også f.eks. de danske computer producenter. Danmark begyndte at udvikle computere i 1960'erne, og denne udvikling fortsatte frem til starten af 90'erne, men på det tidspunkt var der tale om masseproduktion og en konkurrence så hård, at de danske producenter gik under. Det gjaldt i særdeleshed den danske computerbranches tre gamle flagskibe: Regnecentralen, Chr. Rovsing og Dansk Data Elektronik (DDE).

Forandringer på arbejdspladsen

Indførelsen af computere på arbejdspladsen har indenfor mange brancher forandret arbejdslivet i ganske betydelig grad. Mange fag er kommet under voldsomt pres. Sammenlignet med 1960'erne er der i dag få sekretærer ansat på arbejdspladserne. De ansatte skriver selv deres breve, rapporter, dokumenter osv. på computeren. Tekniske tegnere er kommet under pres fra Computer Aided Design (CAD) stationer, som ingeniører, arkitekter osv. selv anvender ifbm. design, udvikling og projektering. Indenfor industrien har anvendelsen af computere ført til automatisering af stadig flere arbejdsprocesser. Indenfor åndsarbejdet anvendes computeren til skaffe stadig større kontrol over og indsigt i dette arbejde. En viden der anvendes til mekanisering og automatisering af også disse arbejdsprocesser. Indenfor dette felt er det specielt computerens evne til at lagre informationer om arbejdsprocessen og genfinde disse igen, der er de vigtigste.

Konsekvensen er, at der stilles langt større sproglige krav og krav til abstrakt tænkning på arbejdsmarkedet i dag. For 20 år siden handlede det om, ikke «at være bange for computeren», at turde sætte sig ind i, hvordan den betjentes og hvad den kunne. I starten af det 21. århundrede handler det om at være rede til de konstante forandringer i arbejdsprocessen, anvendelsen af computere medfører. Disse krav kan være udfordrende, men er også skadelige for mange. (Se: Psykisk arbejdsmiljø). På mange arbejdspladser med et stærkt computer baseret arbejde holder arbejderne kun få år, før de søger bort pga. stress og generelt dårligt arbejdsmiljø. Det gælder i ekstrem grad indenfor selve computer branchen, hvor det kun er de færreste der holder til 60-70 timers timers ugentligt arbejde i mere end 5-10 år. Et andet problem er isolation og instrumentaliseringen af de sociale relationer, hvor samarbejde og samvær tendentielt erstattes af arbejde ved skærmen og kommunikation via emails. Sådan behøver det naturligvis ikke at være, men er et udtryk for, at den teknologiske udvikling ikke drives udfra hensynet til mennesker men udfra hensynet til profit. Den voldsomme og konstante udrensning af virksomheder indenfor computer branchen siden 1960'erne er blot det ultimative eksempel på dette.

Computerens opbygning

Selvom de komponenter der anvendes til fremstilling af computere er ændret dramatisk siden 1940'ernes radiorør, over transistorer til vore dages komplekse integrerede kredsløb, så baserer de fleste af nutidens computere sig fortsat på von Neumann arkitekturen, der blev udviklet af John von Neumann i starten af 40'erne. Den består grundlæggende af 4 dele:

- regneenheden (den aritmetisk-logiske enhed (eng. Arithmetic and Logic Unit, ALU))

- lageret der indeholder data og programmer (eng. Memory)

- ind- og udgangsforbindelser til omverdenen - f.eks. skærm, tastatur (eng. Input/Output, I/O)

- kontrolenheden der styrer de 3 øvrige enheder og fortolker programinstruktionerne i lageret

Disse dele er indbyrdes elektrisk forbundne (eng. Bus).

Regneenheden tager sig af de egentlige beregninger i computeren. Den kan grundlæggende gennemføre aritmetiske operationer (addition, subtraktion, multiplikation, division), logiske operationer og sammenligninger af data. I dag rummer de fleste computere en regneenhed både til faste tal (heltal) og «flydende tal» (realtal).

Lageret rummer de informationer computeren arbejder på - dvs. dens instruktioner og dens data. Selvom de fysisk ligger i samme lager, vil program og kontrolenhed søge at holde dem skarpt adskilt, for under normale forhold må data ikke kunne afvikles som program. Lageret vil normalt være opdelt i forskellige lag afhængigt af hvor hurtigt data skal tilgåes. I vore dages hurtige mikroprocessorer vil der ofte ligge et lille men meget hurtigt lager på samme chip som regne- og kontrolenheden. Den kaldes en «cache» og anvendes til at reducere trafikken til ydre lagerenheder. Derved kan maskinens regnekraft øges. Næste lag efter cache laget eller lagene er RAM eller ROM lager. Det er lager der er lidt langsommere end cachen, men til gengæld langt større - typisk en faktor 100 større. De mikrocomputere der blev produceret for 20 år siden kunne typisk rumme 640Kb (kilo-byte, hvor hver byte består af 8 bit, altså 640.000 * 8 bit data), mens vore dages nye maskiner ofte starter ved 256Mb. ROM (eng. Read Only Memory) kan kun læses, ikke skrives, og anvendes i PC'er til at rumme maskinens BIOS (Basic I/O System), der er det grundlæggende programmel til at starte maskine op, teste dens funktioner og starte indlæsningen af et operativsystem. RAM (eng. Random Access Memory) kan i modsætning til ROM også skrives, hvilket er nødvendig for at gøre computeren generelt anvendelig. Oftest anvendes dynamiske RAM IC'er, hvor hver bit på chippen er implementeret med en kondensator og en transistor. Bittens værdi ligger som ladning på kondensatoren, men denne taber ladningen så hurtigt, at værdien skal genopfriskes mange hundrede gange i sekundet. Deraf «dynamisk» i modsætning til statiske RAM kredse, hvor hver bit til gengæld fylder langt mere chipareal. «Random» (eng. tilfældig) i RAM refererer til, at tilgangstiden til data er uafhængig af deres placering på chippen. Dette er nemlig i modsætning til 3. lag i lageropbygningen, hvor data er sekventielt lagret - på en disk (hvor de ligger i tusindvis af cirkulære spor) eller på magnetbånd. Tilgangstiden til data er her afhængigt af, hvor lang tid der går, før data fysisk passerer forbi læsehovedet. På en moderne harddisk tager det gennemsnitligt 5-10 millisekunder, på en floppydisk nogle hundrede mS, mens det på magnetbånd kan tage minutter. Denne lagringsform er derfor betydeligt langsommere, men til gengæld meget billig. Typisk rummer det 3. lag en faktor 100 gange flere bits end 2. lag.

Teknisk har lagrene gennemgået en enorm udvikling fra de første lagre, hvor relæer blev anvendt, over radiorør, til ferritkernelagre, transistorer og vore dages DRAM kredse med over over 100 millioner bits. Tilsvarende har de ydre lagerenheder udviklet sig fra akustiske forsinkelseskredsløb, papirstrimmel, hulkort til disksystemer med en enorm kapacitet.

Kontrolenheden afvikler programmets instruktioner og styrer de øvrige enheder. Det starter med et hente indholdet af en lagercelle, der rummer en instruktion. Denne instruktion fortolkes i kontrolenheden. Der hentes evt. nødvendige data fra lageret, om nødvendigt sættes regneenheden til at behandle disse data, og data gemmes evt. i lageret. Kontrolenheden kan herefter gå videre til næste instruktion. Ofte er de dyreste dele i en computer dens programmer. Det er derfor en fordel at kunne sælge de samme programmer til mange maskiner. Det kræver imidlertid, at computerne kan anvende de samme programmer, har det samme instruktionssæt. Dette har bidraget til at give Intel et næsten totalt monopol på mikroprocessorer. I 70'erne og frem til slutningen af 80'erne fandtes der mange forskellige mikroprocessorer, med hvert deres instruktionssæt og sæt af programmer. Men PC udviklingen baseret på Intels mikroprocessorer gjorde fra starten af 90'erne Intel næsten enedominerende. Pga. den nordamerikanske anti-monopol lovgivning blev Intel dog tvunget til at acceptere, at flere mindre konkurrenter producerede mikroprocessorer med det samme instruktionssæt som Intels. Mens arkitekturen grundlæggende er fra 40'erne, er instruktionssættet grundlæggende fra 70'erne.

I/O enhederne giver computeren mulighed for kommunikation med omverdenen. Modtage data der behandles og returnere data der fortolkes af mennesker eller anvendes til styring af andre maskiner. Vore dages PC'er har som typiske I/O enheder: tastatur, mus, modem, netkort, printer, scanner. Men i industrielt anvendte maskiner kan der også være tale om enheder til opsamling af elektriske data - om f.eks. døres status i et tog - og til styring af andre enheder - f.eks. dørens lukkemekanisme.

Vore dages mikroprocessorer består af mange millioner transistorer og rummer ofte både regne- og kontrolenhed samt det første lag af hukommelsen - cache lageret. De kaldes også for CPU (eng. Central Processing Unit, Centralenheden). Den første IBM PC udviklet i 1981 kørte med en frekvens på 4,88 MHz, mens de hurtigste PC'er nu kører med en hastighed af adskillige GHz. Altså næsten en faktor 1000 hurtigere end de første PC'er. De hurtige mikroprocessorer har imidlertid det tekniske problem, at der er grænser for hvor hurtigt de kan kommunikere med lager- og I/O enheder. Populært sagt er regne- og kontrolenheden så hurtig, at hverken lager eller I/O enhed kan følge med. En fordobling af frekvensen medfører derfor ikke længere en fordobling af computerens ydeevne. De mere avancerede computere udmærker sig ved i stedet at rumme mange CPU'er: 2, 5, 10, 100. Ja, helt op til 10.000 CPU'er er blevet koblet sammen. I disse avancerede supercomputere ligger udfordringen i, at få de mange CPU'er til at arbejde sammen om løsningen af bestemte problemer. Det kan være løsningen af matematiske problemer, simulationer af atmosfæren eller våbensystemer. F.eks. eksisterede der en aftale mellem Sovjetunionen og USA om stop for atomprøvesprængninger. Tidligere blev nye atomvåben testet ved prøvesprængninger, men nu bliver de i stedet «prøvesprængt» på avancerede supercomputere.

Bits, bytes og programmer

Mens vores talsystem er det arabiske 10 tals-system, arbejder computere i 2 tals-systemet, der er velegnet til den digitale elektronik, der kun kan skelne mellem 2 elektriske tilstande. I 10 tals-systemet betyder 123 altså 100×1 + 10×2 + 3. I 2 tals-systemet betyder 1110 altså 8×1 + 4×1 + 2×1 + 1×0 (eller 14 i 10 tals-systemet). Hver position i tallet svarer til en bit. I eksemplet skal der altså anvendes 4 bits til at lagre tallet. Allerede i 60'erne begyndte man at organisere disse sekvenser af bits i multipla af bytes, hvor hver byte er 8 bits. Størrelsen var hensigtsmæssig, fordi de 8 bits i en byte gav 256 forskellige talværdier, eller «plads nok» til at alle bogstaver i alfabetet, tal, specialtegn mv. kunne gemmes i 1 byte. Standardiseringen af konverteringen mellem et 8 bit tal (byte) og et bogstav/tal/specialtegn blev grundlæggende for udvekslingen af information mellem forskellige computerplatforme og fælles I/O enheder som f.eks. skærme og printere.

Lagrene blev derfor allerede fra 60'erne organiseret som multipla af bytes. IBM's første PC fra 1981 arbejdede med en busbredde på 1 byte, AT maskinen nogle år senere med 2 byte og fra slutningen af 80'erne med 4 byte (eller 32 bit). Selv om der i dag gemmes meget andet end tekster i lagret, er størrelsen byte bevaret. Lageret kan også vhja. mange bytes rumme et lydklip, et billede, en videosekvens o.lign. og disse kan udveksles med andre maskiner, når der enighed om en standard for lagringsformatet. Standardisering af formater - uanset om der har været tale om tekst, billeder, lyd, video, eller kommunikationsformater - har derfor haft en central betydning for udbredelsen af computere og disses muligheder. Standardiseringen foregår i dag i internationale organer, men det hænder fortsat, at store EDB virksomheder forsøger at slå deres egne formater fast som «standarder». Det er en praksis IBM tidligere har anvendt, og som f.eks. Microsoft fortsat anvender. Formålet er at skabe sig selv et monopol indenfor bestemte dele af branchen.

Computerens kontrolenhed er ansvarlig for fortolkning af de enkelte instruktioner og dermed afviklingen af programmer. I vore dages computere optager en instruktion en eller flere bytes plads i lageret. I de tidligste computere blev instruktionerne bit for bit lagt ind i lageret af teknikere - f.eks. via vippekontakter på en konsol. Senere udvikledes muligheden for at indlæse instruktionerne fra en papirstrimmel, der var perforeret alt efter om der skulle stå 0 eller 1. Denne form for programmering kaldes maskinprogrammering, fordi der programmeres direkte mod computerens instruktionssæt.

Næste trin i udviklingen af programmeringsmetoder var udviklingen af «assembler» sproget, hvor hver maskininstruktion havde en symbolsk notation. I stedet for at skulle skrive:

1000011101001110011011011111001

kunne programmøren skrive:

ADD A, B

der instruerede computeren om at addere de to tal A og B. Computeren kunne i sagens natur ikke umiddelbart forstå den symbolske notation, men den kunne oversættes til maskininstruktioner. Af computeren selv selvfølgelig - den er ideel til symbolbehandling. Udviklingen af assembler øgede programmørens produktivitet drastisk. Det var langt hurtigere at formulere en instruktion, og programmer blev langt lettere at læse af andre.

Ulempen var dog fortsat, at programmerne var knyttet til en bestemt computer platform - med det samme instruktionssæt. De kunne ikke flyttes til en anden maskine med et andet instruktionssæt. Samtidig måtte der skrives 1 linie for hver maskininstruktion. Næste generation af programmeringsmetoder eller programmeringssprog gik derfor på at abstrahere fra den fysiske computer og på samme linie at kunne udtrykke mere komplekse operationer, der måtte oversættes til mange maskininstruktioner. Af populære programmeringssprog udvikledes i 1950'erne COBOL (Common Business Language - i 1959), der især blev anvendt til programmering af forretningsprogrammer; FORTRAN (Formula Translation - i 1954) der blev anvendt til matematiske beregninger, simuleringer mm; BASIC (1965) der oprindeligt var et simpelt undervisningssprog til at lære studerende at programmere computere; og C (1972) der bl.a. blev anvendt til at skrive operativsystemer i, der let kunne flyttes til andre maskinplatforme.

Udviklingen af stadig kraftigere programmeringssprog var en betingelse for at øge programmørenes produktivitet. Denne udvikling fortsatte gennem 80'erne og 90'erne, men lige så vigtig for udviklingen af avancerede men samtidig relativt billige computere var skabelsen af et massemarked for programmer. Den generelle billiggørelse af maskinellet og standardiseringen af fælles platforme - specielt PC arkitekturen - har bidraget til at skabe dette massemarked. Hardware- og software (programmel) udviklingen har i den forstand været dialektisk forbundne. Billigere hardware har udbredt PC'erne og computerkraft generelt, hvilket har skabt et massemarked for programmel. Programmerne er blevet relativt billigere (ifht. deres funktionalitet), hvilket har muliggjort flere anvendelser, hvilket igen har befordret spredningen af computere.

Siden starten af 1990'erne har software giganten Microsoft i tiltagende grad skabt sig et monopol indenfor program-produktionen. Gennem 80'erne og frem til midten af 90'erne gjorde en række virksomheder sig gældende med innovative programmer. VisiCalc og Lotus producerede regnarks programmer. Wordperfect producerede tekstbehandlingsprogrammer. Og fra starten af 90'erne begyndte Netscape at producere internet browsere. Microsoft havde allerede fra starten af 80'erne en dominerende stilling indenfor salget af operativsystemer (DOS) til PC'er. Denne stærke stilling blev gjort til et egentlig monopol med udviklingen af de grafisk baserede Windows operativsystemer i 90'erne. Microsoft benyttede denne monopolsituation til også at skabe sig et monopol på andre programmel områder. Forretningsmetoderne har været grove, er blevet kritiseret af konkurrenterne og har været genstand for en retssag rejst af de nordamerikanske monopolmyndigheder i 1997. De sidste år har Microsoft benyttet denne monopolsituation til at stille stadig skrappere licensbetingelser overfor sine kunder, og til at kræve uforholdsmæssigt høje priser. Dette monopol er muligvis truet af den succes operativsystemet Linux og Open Source programmer (offentligt tilgængelige programmelkildetekster) har haft de seneste år. Hele denne proces startede i 1984, da amerikaneren Richard Stallman sagde sit job op på MIT i protest mod de store computer virksomheders hemmeligholdelse af programmeludviklingen. Stallman startede interesseorganisationen GNU, der havde til formål at udvikle offentligt tilgængelige programmer, der udmærkede sig ved at være gratis, og ved at programmernes «kildekode» var offentlig. Det ansporer til en hastig og omfattende spredning af programmer, til at opdagede fejl rettes, men samtidig er de en voldsom trussel mod programmel virksomhederne, der ikke længere kan tjene penge på deres programmer. Linux og Open Source er en del af GNU konceptet, og er i disse år ved at nå en kritisk masse, der gør dem attraktive som alternativ til Microsoft monopolet.

Trusler udefra - virus og overvågning

Computervirus er programmer, der installeres på computeren uden ejerens vidende og som har en ondsindet hensigt. De første programmer af denne type kom frem i 70'erne, og spredtes hastigt med dels udbredelsen af computernetværk, dels spredningen af private PC'er. Disse programmer kunne i værste fald ødelægge maskinen, eller slette dele af eller alle brugerens data. Allerede fra starten af 80'erne voksede der derfor en industri frem, der producerede programmer til bekæmpelse af disse vira. Fra slutningen af 90'erne har de email eller generelt internet bårne vira været de mest populære, og samtidig de mest farlige, fordi de kan spredes lynhurtigt. Efterretningstjenesterne har også udnyttet denne udvikling ved at hyre tidligere virusprogrammører til at udvikle programmer, der kan skaffe efterretningstjenesterne adgang til andres computere.

Et andet aspekt ved sammenkoblingen af computere i netværk - specielt - internettet - er overvågningsmulighederne. USA driver sammen med en række allierede Echelon projektet, der anvendes til at aflytte kommunikationen på internettet, der i de fleste tilfælde sendes i klartekst - hvor det direkte er muligt at læse email mv. - eller hvor krypteringen er så svag, at den ikke volder problemer for efterretningstjenesternes computere. Ifbm. terrorlovgivningen i Danmark blev det i 2002 vedtaget, at internet udbydere skal opbevare deres kunders emails og øvrige internettrafik i 2 år. Mens der ikke har været megen aktivitet i Danmark omkring dette emne - med undtagelse af EDB fagforeningen PROSA - har borgerrettighedsgrupper i andre lande - specielt USA - udfoldet megen aktivitet omkring bekæmpelse af denne udvikling. På den ene side står statsmagten, der argumenterer med behovet for at bekæmpe terrorisme og organiseret kriminalitet, og som derfor ønsker at få adgang til den elektroniske kommunikation. På den anden side står hensynet til den enkeltes ret, privatlivets fred og hjemmets ukrænkelighed. Problemet ville have et mere begrænset omfang, hvis alle stater altid holdt sig indenfor lovens rammer, men historien har vist, at dette sjældent er tilfældet i længere perioder. Efterretningstjenester har ofte ulovligt udspioneret egne medborgere, og i perioder er der kommet partier til magten - som nazisterne i Tyskland i 30'erne - som systematisk har knægtet menneskerettighederne.

Sidst ajourført: 1/5 2003

Læst af: 61.824